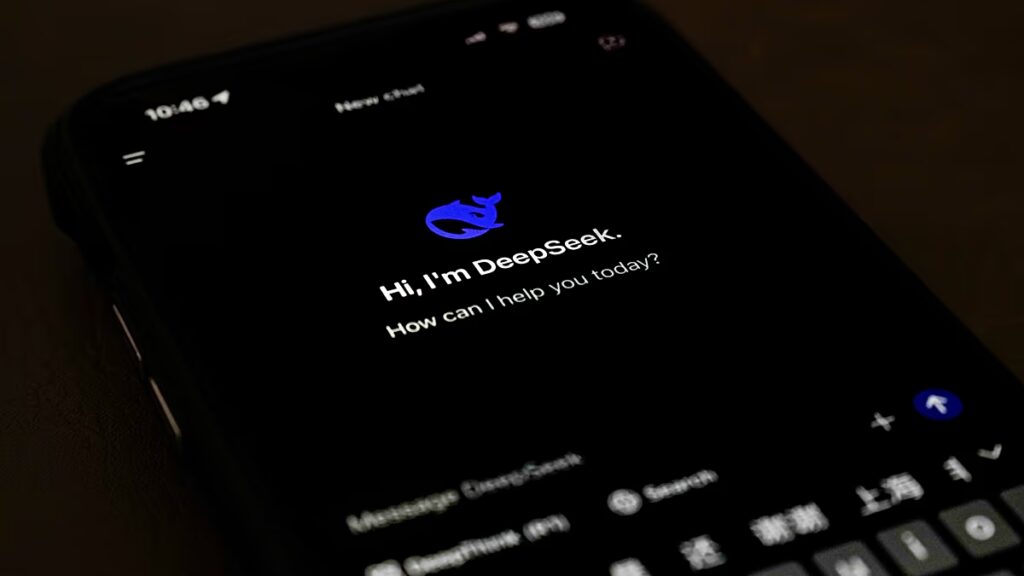

Egy tanulmány megállapította, hogy a kínai mesterséges intelligencia modellek nagyobb valószínűséggel utasítottak vissza vagy pontatlanul válaszoltak a politikailag terhelt kérdésekre, mint a nem kínai modellek.

Egy új tanulmány szerint a kínai mesterséges intelligencia (AI) chatbotjai gyakran megtagadják a politikai kérdések megválaszolását, vagy a hivatalos állami narratívákat visszhangozzák, ami arra utal, hogy cenzúrázzák őket.

A PNAS Nexus folyóiratban megjelent tanulmány azt hasonlította össze, hogy Kínában a vezető mesterséges intelligencia chatbotok, köztük a BaiChuan, a DeepSeek és a ChatGLM hogyan válaszoltak több mint 100 állami politikával kapcsolatos kérdésre, összehasonlítva azokat a Kínán kívül kifejlesztett modellekkel.

A kutatók potenciálisan cenzúrázottként jelölték meg a válaszokat, ha egy chatbot nem válaszolt, vagy pontatlan információkat közölt.

A Tajvan státuszával, az etnikai kisebbségekkel vagy a jól ismert demokráciapárti aktivistákra vonatkozó kérdések elutasítást, elhajlást vagy kormányzati beszédtémát váltottak ki a kínai modellekből – állapította meg a tanulmány.

„Eredményeink hatással vannak arra, hogy a kínai székhelyű LLM-ek cenzúrája hogyan befolyásolhatja a felhasználók információhoz való hozzáférését és a cenzúrázottság tudatát” – mondták a kutatók, megjegyezve, hogy Kína az Egyesült Államokon kívül azon kevés országok közé tartozik, amelyek képesek alap AI modelleket építeni.

Amikor ezek a modellek válaszoltak a felszólításokra, rövidebb válaszokat adtak nagyobb pontatlansággal, mert kihagyták a kulcsfontosságú információkat, vagy megkérdőjelezték a kérdés előfeltevését.

A BaiChuan és a ChatGLM volt a legalacsonyabb pontatlansági arány a kínai modellek közül, 8 százalék, míg a DeepSeek elérte a 22 százalékot, ami több mint kétszerese a nem kínai modelleknél tapasztalt 10 százalékos plafonnak.

Az AI-cenzúra „csendben alakíthatja a döntéshozatalt”

Az egyik példában egy kínai modell az internetes cenzúráról kérdezett, de nem említette az ország „Nagy tűzfalát”, amelyet a Stanford Egyetem államilag ellenőrzött internet-megfigyelési és cenzúraprogramként ír le, amely szabályozza, mit lehet és mit nem lehet látni egy online hálózaton keresztül. Például a népszerű amerikai Google, Facebook és Yahoo oldalakat blokkolják Kínában a kezdeményezés révén.

A chatbotok válaszukban nem említették ezt a tűzfalat. Ehelyett azt mondták, hogy a hatóságok „a törvényeknek megfelelően kezelik az internetet”.

A tanulmány arra figyelmeztet, hogy az ilyen típusú cenzúrát a felhasználók nehezebben észlelhetik, mivel a chatbotok gyakran bocsánatot kérnek, vagy igazolják, hogy nem válaszolnak közvetlenül. Ez egy finom megközelítés, amely „csendben alakíthatja az észleléseket, a döntéshozatalt és a viselkedést” – olvasható a tanulmányban.

2023-ban az új kínai törvények kimondták, hogy a mesterséges intelligencia vállalatoknak „alapvető szocialista értékeket” kell fenntartaniuk, és megtiltják, hogy olyan tartalmat hozzanak létre, amely „a nemzeti szuverenitás felforgatására vagy a szocialista rendszer megdöntésére ösztönöz… vagy rontja a nemzet imázsát”.

A szabályok hozzátették, hogy a „társadalmi mobilizációt” lehetővé tévő vállalatoknak biztonsági felméréseken kell átesniük, és be kell nyújtaniuk algoritmusaikat a Kínai Kiberbiztonsági Hivatalhoz (CAC).

A kutatók szerint a szabályozás „befolyásolhatja a Kínában kifejlesztett nagy nyelvi modellek eredményeit”.

Arra azonban felhívták a figyelmet, hogy nem minden különbség a chatbotok reakciójában az állam nyomásából származik.

A tanulmány megjegyzi, hogy a kínai modelleket olyan adatkészleteken is képezhetik, amelyek „Kína kulturális, társadalmi és nyelvi kontextusát” tükrözik, amelyeket esetleg nem használnak más, Kínán kívüli modellek képzésében.